NVIDIA AI a lansat OpenReasoning-Nemotron, o familie de modele lingvistice mari (LLM) concepute pentru a excela în sarcini complexe de raționament în matematică, știință și programare. Această suită de modele – cuprinzând versiuni cu 1.5B, 7B, 14B și 32B de parametri – a fost distilată din modelul DeepSeek R1 0528 de 671B parametri, capturând capacitățile sale superioare de raționament în modele semnificativ mai mici și mai eficiente.

Această lansare poziționează NVIDIA ca un contributor important în ecosistemul LLM open-source, oferind modele care depășesc performanțele de ultimă generație (SOTA), rămânând în același timp comercial permisive și larg accesibile prin Hugging Face.

1. Prezentare generală a modelului și arhitectura

La baza OpenReasoning-Nemotron se află o strategie de distilare care transferă capacitatea de raționament de la DeepSeek R1 – un model masiv de 671B parametri – în arhitecturi mai mici. Procesul prioritizează generalizarea raționamentului față de simpla predicție de token-uri, permițând modelelor compacte să funcționeze eficient la sarcini structurate, cu o mare încărcătură cognitivă.

Setul de date de distilare pune accent pe matematică, știință și limbaje de programare, aliniind capacitățile modelului cu domenii cheie de raționament.

Ce înseamnă distilarea modelelor?

Distilarea modelelor este o tehnică de transfer de învățare în care un model mai mic este antrenat să imite comportamentul unui model mai mare și mai complex, numit „model teacher”.

Scopul este de a crea un model „student” care este eficient și performant, dar care necesită mai puține resurse computaționale.

2. Variante de modele și specificații

Cele 4 variante OpenReasoning-Nemotron sunt:

OpenReasoning-Nemotron-1.5B

Acest model poate funcționa pe echipamente cu caracteristici tehnice reduse (inclusiv pe telefoane mobile) și este destinat raționamentului și inferenței minime.

OpenReasoning-Nemotron-7B

Acesta este un model cu raționament de scară medie, bun pentru cod/matematică.

OpenReasoning-Nemotron-14B

Acest model se remarcă prin capacități avansate de raționament.

OpenReasoning-Nemotron-32B

Acesta este cel mai avansat model și are o performanță aproape de modelul de ultimă generație la sarcini logice intensive.

Toate modelele sunt compatibile cu arhitecturile transformer, suportă cuantificarea FP16/INT8 și sunt optimizate pentru GPU-urile NVIDIA și framework-urile NeMo.

Ce este cuantificarea?

Cuantificarea este o tehnică folosită pentru a reduce dimensiunea și complexitatea unui model, prin reprezentarea parametrilor cu mai puține biți. Acest lucru reduce cerințele de memorie și viteza de procesare, fără o pierdere semnificativă a performanței.

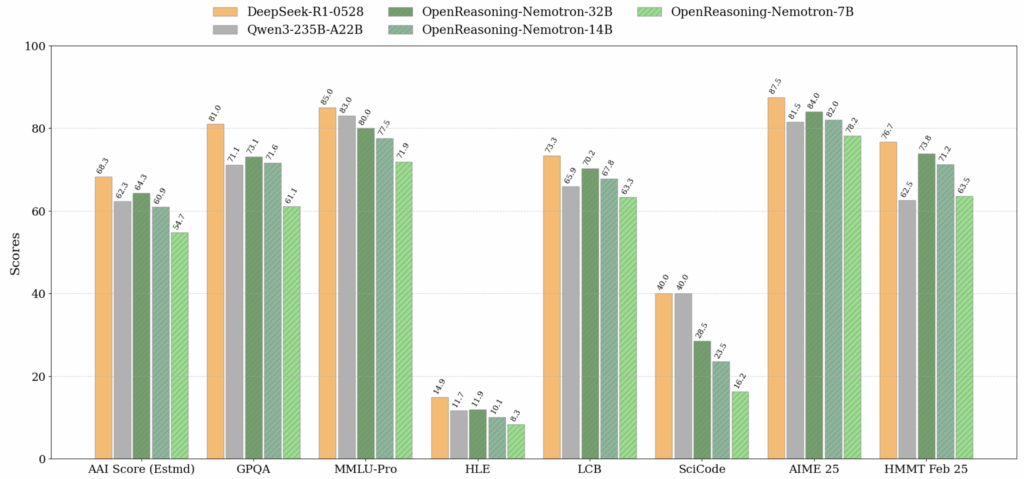

3. Performanța testelor de referință

Aceste modele stabilesc scoruri noi de ultimă generație pe mai multe teste de referință de raționament.

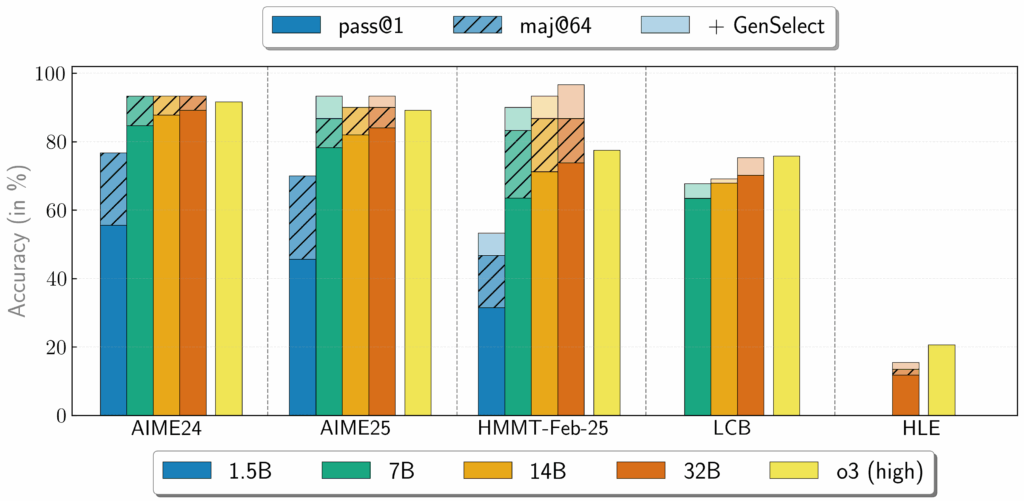

Modelele OpenReasoning-Nemotron pot fi utilizate într-un mod „avansat” prin lansarea mai multor generări în paralel și combinarea acestora prin selecția generativă a soluțiilor (GenSelect). Pentru a adăuga această „abilitate”, s-a folosit procesul de antrenament GenSelect original, cu excepția faptului că nu antrenarea nu s-a făcut pe rezumatul selecției, ci pe întregul traseu de raționament al modelului DeepSeek R1 0528 671B.

Cu acest mod de inferență „avansat” GenSelect, modelul OpenReasoning-Nemotron-32B se apropie și uneori depășește scorurile o3 la evaluările pentru matematică și programare.

Acest lucru demonstrează o performanță puternică a raționamentului emergent la scară.

Ce este GenSelect?

GenSelect este o tehnică utilizată pentru a îmbunătăți precizia modelelor lingvistice prin generarea mai multor răspunsuri posibile și selectarea celui mai bun dintre ele. Prin generarea unui set de candidați și apoi evaluarea lor, GenSelect poate îmbunătăți semnificativ calitatea rezultatelor.

4. Datele de antrenament și specializarea în raționament

Corpusul de antrenament este un subset distilat, de înaltă calitate, al setului de date DeepSeek R1 0528. Caracteristici cheie includ:

- date de raționament atent selectate din discipline matematice, științifice și de informatică;

- ajustare fină inginerită prin solicitare concepută pentru a consolida lanțurile de gândire în mai mulți pași;

- accent pe coerență logică, satisfacerea constrângerilor și raționament simbolic.

Această selecție deliberată asigură o aliniere puternică cu problemele de raționament din lumea reală, întâlnite atât în mediul academic, cât și în domeniile ML aplicate.

5. Concluzie

Modelele OpenReasoning-Nemotron de la NVIDIA oferă o abordare pragmatică, open-source, pentru extinderea capacității de raționament fără costuri de calcul la scară frontieră.

Prin distilarea din DeepSeek R1 de 671B parametri și prin concentrarea pe domenii de raționament cu impact ridicat, aceste modele oferă un echilibru puternic între acuratețe, eficiență și accesibilitate.

Pentru dezvoltatori, cercetători și companii care lucrează la aplicații AI intensive în logică, OpenReasoning-Nemotron oferă o bază convingătoare – lipsită de compromisurile care adesea însoțesc modelele proprietare sau suprageneralizate.