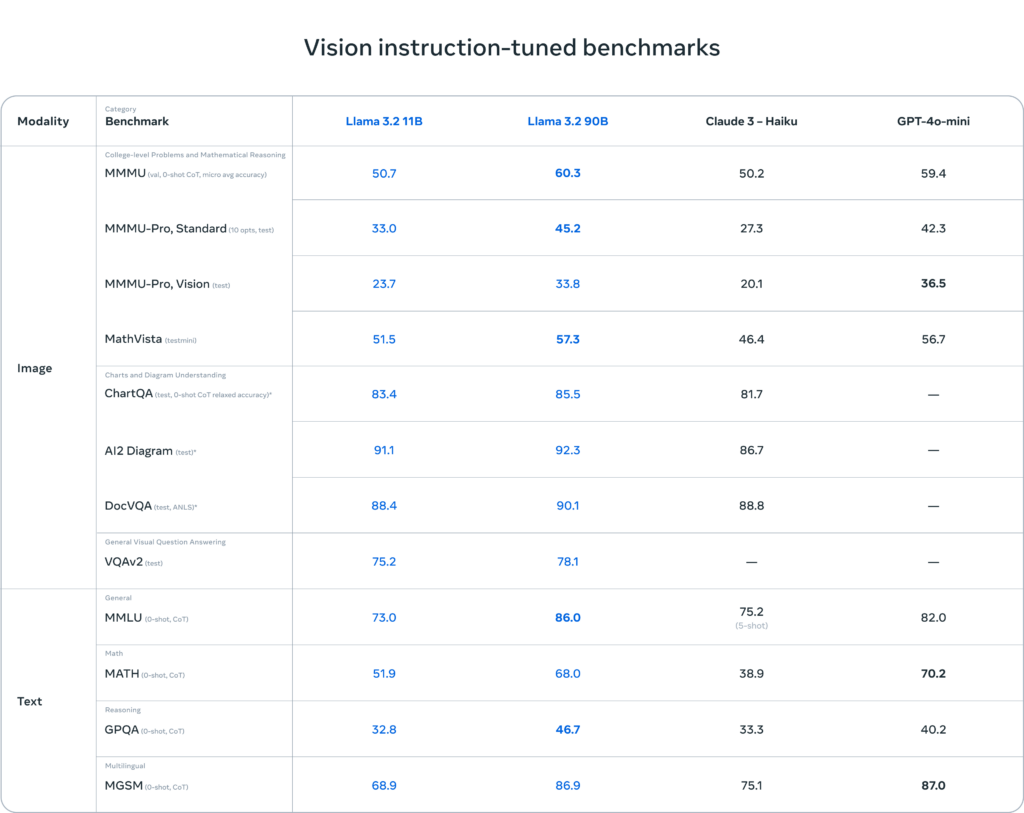

Meta a lansat de curând unul din cele mai bune modele multimodale LLM – Llama 3.2 vision.

1. Introducere Llama 3.2

Llama 3.2 este o nouă versiune a unui model de inteligență artificială care poate înțelege și procesa texte și imagini. Acest model este special pentru că poate funcționa și pe dispozitive mobile (fiind lansat în mai multe variante – 1B, 3B, 11B și 90B), ceea ce înseamnă că poate fi utilizat în aplicații care necesită procesare rapidă și sigură a datelor.

Modelele Llama 3.2 pot fi utilizate pentru a rezuma texte, a urmări instrucțiuni și a rescrie texte. De asemenea, pot înțelege imagini și pot extrage informații din ele.

Unul dintre avantajele acestui model este că poate funcționa local, pe dispozitivul utilizatorului, ceea ce înseamnă că datele nu sunt trimise în cloud și nu sunt accesibile de către terți. Acest lucru îl face mai sigur și mai privat.

Llama 3.2 este disponibil pentru descărcare și poate fi utilizat de dezvoltatori pentru a crea aplicații care necesită procesare avansată de texte și imagini.

Modelele Llama 3.2 1B și 3B suportă lungimea contextului de 128K tokeni și pot fi folosite în aplicații business cum ar fi rezumarea, urmărirea instrucțiunilor și rescrierea sarcinilor care rulează pe dispozitivele locale. Aceste modele sunt activate implicit hardware-ul Qualcomm și MediaTek și sunt optimizate pentru procesoare Arm.

Llama 3.2 este primul model Meta care permite computer vision, iar pentru a face acest lucru posibil a fost nevoie de regândirea întregii arhitecturii de înțelegere a imaginilor.

Pentru că Meta are o dispută privind utilizarea datelor personale ale cetățenilor europeni pentru antrenarea modelelor sale, accesul direct la platforma modelului LLM este interzis:

Dar, modelele pot fi descărcate de pe platforme specializate de tip HuggingFace sau pot fi folosite de pe platformele care oferă soluții AI precum Groq.

2. Exemple de utilizare Llama 3.2 vision

În testele de azi vom folosi capacitățile de computer vision ale noului model în versiunea de 11 B parametri prin API-ul pus la dispoziție de Groq.

Pentru aceasta vom utiliza următorul exemplu de cod python:

from groq import Groq

import base64

# Function to encode the image

def encode_image(image_path):

with open(image_path, "rb") as image_file:

return base64.b64encode(image_file.read()).decode('utf-8')

# Path to your image

image_path = "path_to_your_image.jpg"

# Getting the base64 string

base64_image = encode_image(image_path)

client = Groq()

chat_completion = client.chat.completions.create(

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": "What's in this image?"},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}",

},

},

],

}

],

model="llama-3.2-11b-vision-preview",

)

print(chat_completion.choices[0].message.content)unde path_to_your_image.jpg sunt imaginile aflate pe dispozitivul local.

Vom testa atât capacitatea de a indentifica textul din imagini, dar și capacitatea de înțelegere a conținutului imaginilor și de generare a unei descrieri pentru acestea.

Vom începe cu imagine dintr-un restaurant:

Llama 3.2 vision generează următoarea descriere:

In the image, there are three wooden blocks displaying prime cuts of raw ribeye in a kitchen and bar setting. The ribeye steaks appear to be freshly cut and ready to be cooked in the kitchen. Apart from the ribeyes, the kitchen is adorned with various liquor bottles and bar items, such as a knife, which adds a sense of atmosphere to the scene.Vom continua cu o altă imagine:

iar modelul generează următoarea descriere:

The image shows a woman standing next to a statue that is large and quite unique due to its white color and strange looking facial features. She appears to be interested in the statue, possibly contemplating its artistic value or simply admiring the creative work displayed in the room.Până acum modelul Llama 3.2 vision se descurcă foarte bine.

Pentru următoarea imagine vom cere modelului și o interpretare:

Modelul nu pare să înțeleagă contextul umoristic al imaginii și răspunde doar cu ceea ce sesizează:

In the image, a man and a woman are sitting on a wooden park bench, sharing a loving gesture such as placing their hands on each other. The couple appears to be enjoying a romantic, outdoor moment together. Additionally, there are two more wooden benches visible in the scene. One bench is positioned at the left side while the other bench is located at the right side. The overall atmosphere portrayed by the couple suggests a peaceful, serene location.

Vom testa în continuarea capacitatea Lllama 3.2 vision de a recunoaște text din imagini.

Răspunsul este:

Sure, here is the text extracted from the image in a JSON format:

[

{

"Title": "The Art of Dressing",

"Subtitle": "Expressing Identity Through Personal Style",

"Content": [

{

"Title": "How Fashion Choices Reflect and Influence Individuality and Culture",

"Body": "Lorem ipsum dolor sit amet, consectetur adipiscing elit. Nullam vulputate magna at justo commodo, ut sagittis est tacle. Duis imperdiet elementum erat, ut varius tellus rutrum et. Suspendisse quis feugiat libero mollis molestie vel dolor luctus. Mauris molestie vel dolor luctus."

},

{

"Title": "Fashion and Self-Perception",

"Body": "Lorem ipsum dolor sit amet, consectetur adipiscing elit. Nullam vulputate magna at justo commodo, ut sagittis est tacle. Duis imperdiet elementum erat, ut varius tellus rutrum et. Suspendisse quis feugiat libero mollis molestie vel dolor luctus. Mauris molestie vel dolor luctus."

},

{

"Title": "Fashion and Social Change",

"Body": "Lorem ipsum dolor sit amet, consectetur adipiscing elit. Nullam vulputate magna at justo commodo, ut sagittis est tacle. Duis imperdiet elementum erat, ut varius tellus rutrum et. Suspendisse quis feugiat libero mollis molestie vel dolor luctus. Mauris molestie vel dolor luctus."

},

{

"Title": "Mental Impact of Clothing Choices",

"Body": "Lorem ipsum dolor sit amet, consectetur adipiscing elit. Nullam vulputate magna at justo commodo, ut sagittis est tacle. Duis imperdiet elementum erat, ut varius tellus rutrum et. Suspendisse quis feugiat libero mollis molestie vel dolor luctus. Mauris molestie vel dolor luctus."

}

]

}

]Conținutul este extras fără greșeli.

3. Concluzii

Llama 3.2 vision este un model de dimensiuni reduse (precum Florence-2 sau Qwen2.5-vl) , dar cu performanțe ridicate. Poate fi folosit fără probleme la identificarea textului din imagini și la generarea de descrieri, dar îi este dificil încă să interpreteze contextul imaginilor.

Azi am testat doar varianta mai mică – cea de 11 miliarde de parametri. E posibil însă ca varianta Llama 3.2 vision 90B să genereze texte mult mai complexe.

Modelul vine și în variantele instruct care fac mai ușoară posibilitatea de a antrena LLM-ul pe un set de date proprietare ceea ce crește și mai mult precizia și finețea pentru aplicațiile speciale.

Modelul nu necesită resurse mari de utilizare (e suficient o placă grafică de 12 GB RAM pentru varianta 11B) și prezintă o viteză de răspuns extraordinar de bună atunci când e folosit cu Groq.