În acest articol, vom explora în detaliu ce este Mistral Mamba, care sunt caracteristicile sale cheie, cum funcționează arhitectura sa, cum se compară cu modelele Transformer tradiționale și care sunt potențialele sale aplicații.

În ultimii ani, domeniul inteligenței artificiale a cunoscut o evoluție remarcabilă, în special în ceea ce privește modelele de limbaj de mari dimensiuni (LLM). Printre cele mai recente inovații se numără Mistral Mamba, o arhitectură nouă care promite să redefinească modul în care procesăm secvențele de date în inteligența artificială.

1. Ce este Mamba?

Mamba este o nouă arhitectură pentru modelele de limbaj de mari dimensiuni, dezvoltată de cercetători de la universitățile Carnegie Mellon și Princeton. Aceasta a fost concepută pentru a aborda unele dintre limitările modelelor Transformer, în special în ceea ce privește procesarea secvențelor lungi de date.

Mistral Mamba se bazează pe modelul de secvență de spațiu de stare structurat (S4), care combină cele mai bune caracteristici ale modelelor recurente, convoluționale și continue în timp. Această abordare permite Mamba să gestioneze eficient dependențele pe termen lung, să manipuleze date eșantionate neregulat și să mențină o eficiență computațională ridicată atât în timpul antrenamentului, cât și în timpul inferenței.

Un aspect cheie al arhitecturii Mistral Mamba este utilizarea spațiilor de stare selective (SSM). Acestea permit modelului să filtreze dinamic informațiile, concentrându-se doar pe datele relevante din secvențe. Acest mecanism de selecție modifică parametrii modelului de spațiu de stare structurat (SSM) în funcție de input, permițând Mistral Mamba să treacă de la un cadru invariant în timp la unul variant în timp.

2. Caracteristici cheie și inovații

Mamba aduce o serie de inovații semnificative în domeniul modelelor de limbaj:

- Arhitectură simplificată: Mistral Mamba înlocuiește blocurile complexe de atenție și MLP specifice Transformerilor cu un singur bloc SSM coeziv. Această simplificare duce la un model mai ușor și mai rapid.

- Scalabilitate liniară: Spre deosebire de modelele Transformer, Mistral Mamba se scalează liniar cu lungimea secvenței. Acest lucru îi permite să proceseze secvențe mult mai lungi fără a crește dramatic timpul de calcul sau consumul de memorie.

- Spații de stare selective (SSM): Aceste componente permit modelului să proceseze informațiile în mod selectiv, în funcție de inputul curent. Acest lucru îi permite să filtreze eficient datele irelevante și să se concentreze pe informațiile importante.

- Paralelism optimizat pentru hardware: Mistral Mamba utilizează un algoritm paralel conceput special pentru eficiență hardware, ceea ce îi permite să obțină performanțe superioare pe GPUuri moderne.

- Invarianță liniară în timp (LTI): Această caracteristică, moștenită din modelele S4, asigură că parametrii modelului rămân constanți în toate etapele de timp, oferind consistență în dinamica modelului.

- Inferență rapidă: Datorită arhitecturii sale optimizate, Mistral Mamba poate realiza inferența în timp liniar, ceea ce îl face deosebit de eficient pentru procesarea secvențelor lungi.

3. Detalii despre arhitectura Mistral Mamba LLM

Arhitectura Mamba se distinge prin câteva elemente cheie:

- Stratul SSM: În inima arhitecturii Mistral Mamba se află stratul de spațiu de stare selectiv (SSM). Acesta permite modelului să atribuie ponderi diferite fiecărui input, concentrându-se astfel pe datele cele mai relevante pentru sarcina în curs.

- Adaptare dinamică: Mamba poate să se adapteze dinamic la inputuri, ceea ce îi permite să gestioneze eficient o varietate de sarcini de modelare a secvențelor.

- Optimizare pentru GPU: Arhitectura Mamba este concepută să exploateze la maximum puterea de calcul a GPUurilor moderne. Expansiunea stării este proiectată să se încadreze în memoria de mare bandă (HBM) a GPUurilor, reducând timpul de transmisie a datelor și accelerând procesarea.

- Procesare paralelă maximizată: Prin alinierea calculelor sale cu natura paralelă a calculului GPU, Mamba atinge un nivel de performanță care stabilește un nou standard pentru modelele de secvență.

- Gestionarea eficientă a memoriei: Mamba utilizează eficient memoria GPU, ceea ce îi permite să proceseze secvențe foarte lungi fără a epuiza resursele hardware.

4. Mamba vs. Transformers

Pentru a înțelege mai bine impactul potențial al Mistral Mamba, este util să o comparăm cu arhitectura Transformer, care a dominat domeniul NLP în ultimii ani:

Complexitate computațională

- Transformers: O(n^2), unde n este lungimea secvenței.

- Mamba: O(n), scalare liniară cu lungimea secvenței.

Procesarea secvențelor lungi

- Transformers: Performanța scade dramatic pentru secvențe lungi.

- Mamba: Poate procesa eficient secvențe foarte lungi.

Mecanismul de atenție

- Transformers: Utilizează atenție globală, ceea ce poate fi ineficient pentru secvențe lungi.

- Mamba: Folosește spații de stare selective, permițând o focalizare mai eficientă pe informațiile relevante.

Viteza de inferență

- Transformers: Poate fi lentă pentru secvențe lungi.

- Mamba: Oferă inferență în timp liniar, fiind mult mai rapidă pentru secvențe lungi.

Utilizarea memoriei

- Transformers: Consum ridicat de memorie pentru secvențe lungi.

- Mamba: Utilizare eficientă a memoriei, permițând procesarea secvențelor lungi cu resurse limitate.

Flexibilitate

- Transformers: Foarte eficiente pentru o gamă largă de sarcini NLP.

- Mamba: Promite versatilitate similară, cu avantaje suplimentare pentru secvențe lungi și sarcini care necesită memorie pe termen lung.

Este important de menționat că, deși Mamba prezintă avantaje semnificative în ceea ce privește eficiența și scalabilitatea, Transformerii încă excelează în anumite domenii. De exemplu, Transformerii pot gestiona secvențe mai lungi decât pot stoca SSM-urile în memorie, necesită mai puține date pentru a învăța sarcini similare și depășesc SSM-urile în sarcini care necesită recuperarea sau copierea din contextul de intrare, chiar și cu mai puțini parametri.

5. Aplicații ale Mistral Mamba

Potențialul Mistral Mamba de a procesa eficient secvențe lungi și de a se adapta dinamic la diverse tipuri de date îl face adecvat pentru o gamă largă de aplicații:

- Analiza textelor lungi: Mamba poate fi utilizată pentru a analiza și rezuma documente foarte lungi, articole academice sau chiar cărți întregi.

- Procesarea limbajului natural avansat: Poate îmbunătăți sarcini precum traducerea automată, generarea de text și analiza sentimentelor, în special pentru texte lungi și complexe.

- Asistență în codare: Mamba poate fi utilizată pentru a crea asistenți de codare mai eficienți, capabili să înțeleagă și să genereze secvențe lungi de cod.

- Analiza seriilor temporale: În domenii precum finanțele sau meteorologia, Mistral Mamba poate fi folosită pentru a analiza și prezice tendințe bazate pe serii temporale lungi de date.

- Procesarea semnalelor audio și video: Capacitatea de a gestiona secvențe lungi face Mamba potrivită pentru analiza și procesarea semnalelor audio și video de lungă durată.

- Cercetare medicală: În genomică și proteomică, unde se lucrează cu secvențe foarte lungi de date, Mamba ar putea aduce îmbunătățiri semnificative în analiza și predicția structurilor.

- Sisteme de recomandare: Mamba ar putea îmbunătăți sistemele de recomandare prin capacitatea sa de a procesa istoricuri lungi de interacțiuni ale utilizatorilor.

- Chatboți și asistenți virtuali: Arhitectura Mamba ar putea permite crearea de chatboți mai sofisticați, capabili să mențină contexte de conversație mai lungi și mai coerente.

6. Testare Mistral Mamba

Mistral Mamba este disponibil gratuit pe platforma HuggingFace sau poate fi accesat direct prin API de pe Mistral Cloud.

Modelul Mistral Mamba propus de Mistral este antrenat pe 7 miliarde de parametri și are ca puncte tari generarea de cod și analizarea problemelor.

Pentru testele din articolul acesta vom utiliza varianta API care ne asigură un timp de răspuns excelent.

În prealabil va trebui să instalăm librăria de accesare a funcțiillor python specifică modelelor Mistral:

pip install mistralaiUn exemplu de cod este următorul:

import os

from mistralai import Mistral

api_key = os.environ["MISTRAL_API_KEY"]

model = "open-codestral-mamba"

client = Mistral(api_key=api_key)

chat_response = client.chat.complete(

model = model,

messages = [

{

"role": "user",

"content": "What is the best French cheese?",

},

]

)

print(chat_response.choices[0].message.content)Răspunsul Mistral Mamba pentru promptul inițial este:

The "best" French cheese can be subjective and depends on personal preferences. However, some of the most popular and well-known French cheeses include:

1. Brie: This soft, creamy cheese is often served with fruit and is popular in many French dishes.

2. Roquefort: Known for its pungent aroma and strong flavor, Roquefort is a blue cheese that is often used as an ingredient in other dishes.

3. Camembert: This semi-soft cheese is also often served with fruit and is known for its creamy texture.

4. Comté: This aged, hard cheese is known for its strong flavor and is often used in raclette, a popular French dish.

5. Saint-Nectaire: This semi-soft, blue cheese is known for its pungent aroma and is often used in salads and soups.

Ultimately, the best French cheese for you will depend on your personal taste buds and the dishes you plan to use it in.În continuare vom testa cum răspunde la câteva întrebări clasice.

Prima întrebare este problema melcului care urcă în timpul zilei și noapte alunecă:

Un melc se afla pe fundul unei fantani inalta de 20 de metri. Ziua urca 3 metri, iar noaptea aluneca 2 metri. De cate zile are nevoie pentru a ajunge la varful fantanii?Atunci când se rezolvă problema trebuie să se țină cont de parcursul zilnic al melcului, pentru că în momentul când ajunge în vârful fântânii nu mai contează că apoi melcul alunecă 2 metri înapoi.

To calculate how many days it takes for the melc to reach the top of the fantanii, we can use a simple loop in Python. We will start with the initial height of the melc and add or subtract the daily change in height based on whether it's day or night. We will continue this process until the melc reaches the top of the fantanii.

Here's the Python code to calculate the number of days it takes for the melc to reach the top of the fantanii:

```python

# initial height of the melc

height = 0

# daily change in height

day_change = 3

night_change = -2

# initialize the number of days

days = 0

# loop until the melc reaches the top

while height < 20:

# add the day change in height

height += day_change

days += 1

# if it's still not at the top, add the night change in height

if height < 20:

height += night_change

# print the number of days it took

print("It took", days, "days for the melc to reach the top of the fantanii.")

```Dacă rulăm codul acesta funcționează corect:

It took 18 days for the melc to reach the top of the fantanii.În continuare vom cere modelului Mistral Mamba să genereze un cod python pentru a identifica anii bisecți din perioada 2024-2048.

Promptul folosit este:

Generate python code to display the leap years in the period 2024-2048.Iar codul generat este:

Sure, here is a simple Python code snippet that will generate and print all leap years between 2024 and 2048:

```python

def is_leap(year):

return year % 4 == 0 and (year % 100 != 0 or year % 400 == 0)

for year in range(2024, 2049):

if is_leap(year):

print(year)

```

This code first defines a helper function `is_leap(year)` to check if a given year is a leap year. Then it iterates over each year in the range from 2024 to 2048, and if a year is a leap year, it prints it.Dacă rulăm codul vedem lista corectă de ani bisecți:

2024

2028

2032

2036

2040

2044

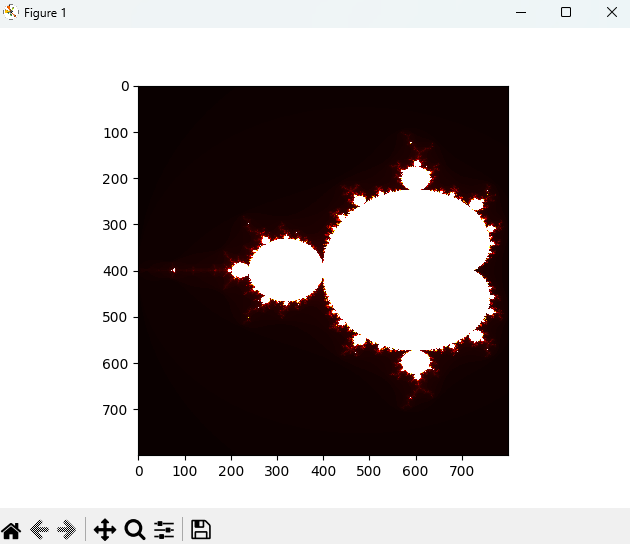

2048Următoarea provocare este generarea unui cod care afișeză o imagine de tip fractal, pe baza următorului prompt:

Generate python code to display a fractal image on the screen.Codul generat este următorul:

Creating a fractal image requires a complex mathematical formula and a graphics library to display it. Here's an example of generating a Mandelbrot set fractal using the Python Imaging Library (PIL) and matplotlib:

```python

import numpy as np

import matplotlib.pyplot as plt

def mandelbrot(c, max_iter):

z = c

for n in range(max_iter):

if abs(z) > 2:

return n

z = z*z + c

return max_iter

def create_fractal(min_x, max_x, min_y, max_y, image, max_iter):

height = image.shape[0]

width = image.shape[1]

pixel_x = (max_x - min_x) / width

pixel_y = (max_y - min_y) / height

for x in range(width):

real = min_x + x * pixel_x

for y in range(height):

imag = min_y + y * pixel_y

color = mandelbrot(complex(real, imag), max_iter)

image[y, x] = color

def display_fractal(image):

plt.imshow(image, cmap='hot', interpolation='none')

plt.show()

def main():

min_x = -2.0

max_x = 0.5

min_y = -1.5

max_y = 1.5

image = np.zeros((800, 800))

max_iter = 256

create_fractal(min_x, max_x, min_y, max_y, image, max_iter)

display_fractal(image)

if __name__ == "__main__":

main()

```

This script creates a fractal image of the Mandelbrot set, which is a set of complex numbers c for which the function f_c(z)=z^2+c does not diverge when iterated from z=0, i.e., for which the sequence f_c(0), f_c(f_c(0)), etc., remains bounded in absolute value. The colors in the image represent the number of iterations before the function diverges.Pentru a putea testa codul va trebui să instalăm libăriile:

pip install numpy matplotlibDacă rulăm codul vom obține o spectaculoasă imagine:

7. Provocări și perspective de viitor

Deși Mamba prezintă avantaje semnificative, există încă provocări și oportunități de îmbunătățire:

- Integrare în ecosistemele existente: Pentru o adoptare largă, Mamba trebuie să fie bine integrată în cadrele și bibliotecile populare de machine learning.

- Îmbunătățirea performanței pe sarcini specifice: Deși Mamba excelează în procesarea secvențelor lungi, este necesară mai multă cercetare pentru a-i îmbunătăți performanța în sarcini specifice unde Transformerii încă domină.

- Optimizarea pentru diverse hardware: Pe măsură ce arhitecturile hardware evoluează, Mamba va trebui să fie optimizată continuu pentru a profita la maximum de noile capacități.

- Scalarea la modele mai mari: Este important să se exploreze cum performanța și eficiența Mamba se mențin atunci când se scalează la modele cu miliarde de parametri.

- Etica și utilizarea responsabilă: Ca orice tehnologie AI avansată, este crucial să se asigure că Mamba este dezvoltată și utilizată într-un mod etic și responsabil.

8. Concluzii

Mistral Mamba reprezintă un pas semnificativ înainte în domeniul modelelor de limbaj de mari dimensiuni. Prin abordarea sa inovatoare bazată pe spații de stare selective, Mamba promite să depășească multe dintre limitările modelelor Transformer actuale, în special în ceea ce privește procesarea secvențelor lungi și eficiența computațională.

Cu toate acestea, este important să recunoaștem că Mamba este încă o tehnologie în curs de dezvoltare. În timp ce potențialul său este imens, va fi nevoie de mai multă cercetare, dezvoltare și testare pentru a-i realiza pe deplin promisiunea. De asemenea, va fi interesant de urmărit cum se va compara și va coexista cu alte arhitecturi emergente în domeniul AI.

Pe măsură ce tehnologia evoluează, putem anticipa că Mamba va juca un rol important în modelarea viitorului inteligenței artificiale, deschizând noi posibilități în procesarea limbajului natural, analiza datelor și multe alte domenii. Rămâne de văzut cum comunitatea de cercetare și industria vor adopta și vor dezvolta în continuare această tehnologie promițătoare.