AI21labs a lansat familia de modele AI open source Jamba 1.5 cu un context impresionant de 256k tokens.

Jamba 1.5 oferă viteză, eficiență și calitate răspunzând criteriilor stabilite de AI21labs de a oferi organizațiilor cele mai bune instrumente AI posibile:

- Fereastră de context mare: Jamba 1.5 are una din cele mai mari ferestre de context de pe piață – de 256k token, ceea ce înseamnă procesarea unui volum uriaș de date;

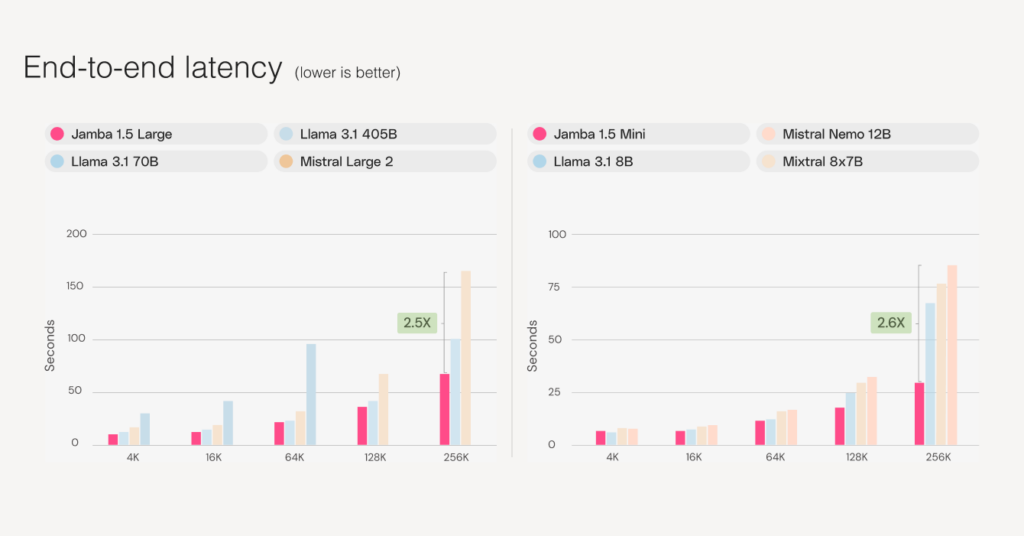

- Viteză: până la de 2.5 viteză mai mare decât alte modele din clasa Jamba 1.5;

- Calitate: testele dovedesc că Jamba 1.5 mini surclasează Mixtral 8x22B, iar Jamba 1.5 Large surclasează LLama 3.1 70B și chiar LLAMA 3.1. 405B;

- Mai multe limbi: sunt suportate limba engleză, spaniolă, franceză, portugheză, italiană, olandeză, germană, ebraică și araba;

- Orientată spre date structurate: modelele AI sunt capabile de apelare la funcțîî, răspuns în format JSON, analiză documente și extragere informații;

- Ușor integrabile: modelele sunt disponibile în format API dar și open source pe platformele consacrate și compatibile cu LongChain sau Llamaindex;

Arhitectură hibridă și eficientizarea utilizării resurselor

Jamba 1.5 Large și Mini sunt construite pe noua arhitectura SM-Transformer Jamba, care îmbină calitatea excepțională a tehologiei Transformer cu eficiența revoluționară a Mamba.

Modelele Jamba 1.5 oferă o amprentă redusă în memorie față de concurență, permitând clienților să gestioneze lungimile contextului până la 140K token pe un singur GPU utilizând Jamba 1.5 Mini. Aceleași avantaje fac și ajustarea fină peste contexte lungi mai ușoară și mai accesibilă decât cu modelele bazate pe Transformer. Mulțumită acestei arhitecturi optimizate pentru eficiență, modelele Jamba 1.5 pot oferi calitate superioară și viteză fără creșterea costurilor.

Ca toate modelele din clasa sa de dimensiune, Jamba 1.5 Large nu poate fi încărcat în totalitate (FP32) sau jumătate (FP16/BF16) cu precizie pe un singur nod de 8 GPU-uri. Din acest motiv AI21labs au dezvoltat ExpertsInt8, o tehnică de cuantificare nouă adaptată modelelor MoE.

Cu ExpertsInt8, se cuantifică numai straturile MoE (sau MLP), care pentru multe modele MoE reprezintă peste 85% din modelu. În acest tip de implementare se folosește o cuantificare intermediară de 8 biți în format INT8, iar informațiile sunt decuantificate ulterior în timpul executării direct în nucleul GPU al MoE.

Această tehnică oferă patru avantaje:

- Este rapidă, cu cuantificare care durează până la câteva minute;

- nu depinde de calibrare, un proces uneori instabil care ordinare poate dura ore sau zile;

- poate utiliza încă BF16 pentru a ține mari activări;

- permite Jamba 1.5 Large să se potrivească pe un singur nod de 8 GPU, utilizând lungimea sa completă de context de 256K.

Viteze mari

Pentru cazurile de utilizare în care organizațiile sunt interesate de asistenți virtuali, suport tehnic pentru și diverese chatbot-uri, rularea rapidă este esențială. Modelul AI trebuie să poată ține pasul cu volumul operațiunilor, chiar și atunci când cererile de utilizare și volumele discuțiilor cresc.

Ambele modele Jamba 1.5 sunt mai rapide decât concurenții de o dimensiune similară, cu o viteză de până la 2,5 ori mai mare pe contexte lungi, oferind clienților avantaje majore în ceea ce privește costurile, calitatea și viteza la utilizare intensă atunci când sunt implementate în propriul lor mediu.

Teste

Pentru testare am folosit platformele online puse la dispoziție de NVIDIA pentru evaluarea modelelor AI.

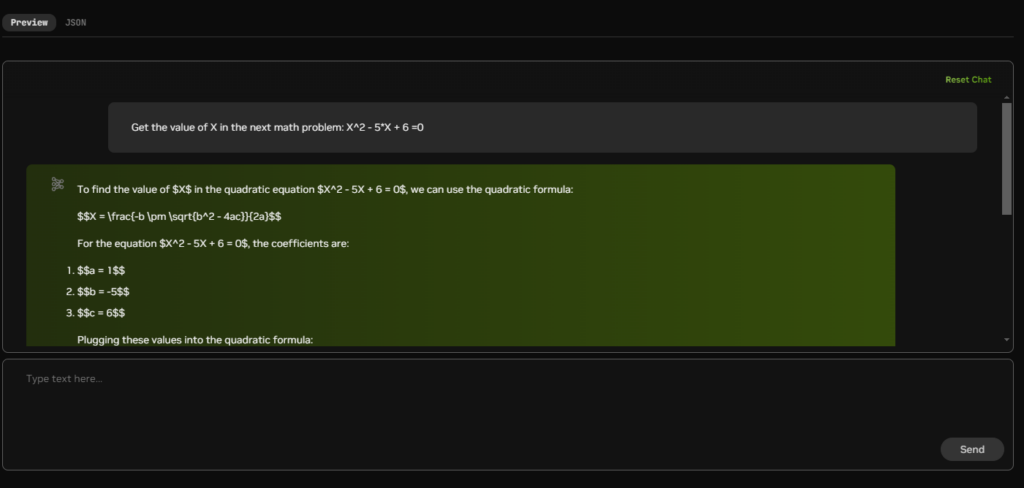

Testarea Jamba 1.5 Mini

Am ales să începen testul cu varianta Mini care are o dimensiune de aproximativ 90 GB ceea ce o face imposibil de instalat pe dispozitivele locale uzuale, modelul nefiind capabil să încapă în memoria VRAM a unei plăci video obișnuite.

Get the value of X in the next math problem: X^2 - 5*X + 6 =0

To find the value of $X$ in the quadratic equation $X^2 - 5X + 6 = 0$, we can use the quadratic formula:

$$X = \frac{-b \pm \sqrt{b^2 - 4ac}}{2a}$$

For the equation $X^2 - 5X + 6 = 0$, the coefficients are:

$$a = 1$$

$$b = -5$$

$$c = 6$$

Plugging these values into the quadratic formula:

$$X = \frac{-(-5) \pm \sqrt{(-5)^2 - 4 \cdot 1 \cdot 6}}{2 \cdot 1}$$

Simplifying inside the square root:

$$X = \frac{5 \pm \sqrt{25 - 24}}{2}$$

$$X = \frac{5 \pm \sqrt{1}}{2}$$

$$X = \frac{5 \pm 1}{2}$$

This gives us two solutions:

$$X = \frac{5 + 1}{2} = \frac{6}{2} = 3$$

$$X = \frac{5 - 1}{2} = \frac{4}{2} = 2$$

So, the values of $X$ are $X = 3$ and $X = 2$.A-a întrebare este de logică:

Dacă Vasile are 3 mere, ii dă un măr Mariei, mai primește 5 mere de la mama sa și ii dă bunicii lui 4 mere, câte mere are Vasile la sfarsit?iar modelul răspunde cu:

Let's break down the problem step by step:

Initial number of apples Vasile has: 3.

Vasile gives one apple to Marie: Vasile now has $3 - 1 = 2$ apples.

Vasile receives 5 apples from his mother: Vasile now has $2 + 5 = 7$ apples.

Vasile gives 4 apples to his grandparents: Vasile now has $7 - 4 = 3$ apples.

So, Vasile has 3 apples at the end.Răspunsul este corect chiar dacă întrebarea a fost pusă în limba română, dar modelul a răspuns în limba engleză.

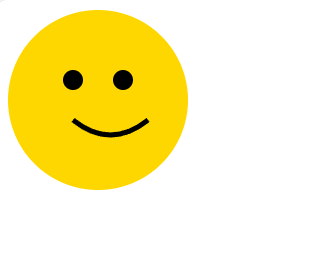

Testarea Jamba 1.5 Large

Fiind un model mai avansat formulat niște sarcini un pic mai dificile:

write the SVG code for an image that resembles a smily face

și modelul a răspuns imediat cu codul:

Sure! Here's an SVG code for a simple smiley face:

<svg width="200" height="200" viewBox="0 0 200 200" xmlns="http://www.w3.org/2000/svg">

<circle cx="100" cy="100" r="90" fill="#FFD700" />

<circle cx="75" cy="80" r="10" fill="#000000" />

<circle cx="125" cy="80" r="10" fill="#000000" />

<path d="M75,120 C100,140 125,140 150,120" stroke="#000000" stroke-width="5" fill="transparent" />

</svg>

This code creates a yellow circle for the face, two black circles for the eyes, and a black curved line for the smile. You can adjust the width, height, and viewBox attributes to change the size of the smiley face.

Continuăm cu întrebări de logică:

Un bărbat şi fiul său biologic au un accident de maşină. Băiatul este dus de urgenţă la spital, direct în sala de operaţii. Medicul chirurg, la vederea pacientului, exclamă, pe bună dreptate: „Dar acesta este fiul meu biologic!”. Cum se pote explica?

Citeşte întreaga ştire: Întrebări de logică - Top 40 de întrebări de logică pentru copii și adulțiDe data aceasta, Jamba 1.5 Large e capabil să răspundă în limba română:

Această întrebare de logică se bazează pe o paradoxă aparentă. Dacă bărbatul este tatăl biologic al băiatului, cum este posibil ca medicul să spună că băiatul este fiul său biologic?

Soluția este că medicul este mama băiatului. Deși termenul "medic" este de obicei asociat cu un bărbat, în acest caz, medicul este femeie și este mama băiatului. Astfel, fiul este biologic al medicului, ceea ce explică exclamarea lui.

În concluzie, paradoxul se rezolvă prin faptul că medicul este mama băiatului, făcător medicul său biologic.Continuăm cu întrebare de logică și matematică:

Sunt de patru ori mai în vârstă decât fiica mea. Peste 20 de ani voi fi de două ori mai în vârstă decât ea. Câți ani avem acum? –și răspunsul:

Pentru a rezolva această problemă, vom folosi ecuații. Să desemnăm cu $x$ vârsta fiicei și cu $y$ vârsta mamei acum.

Condiția 1: Mamei i se potriveste patru ori mai mult decât fiicei.

$$y = 4x$$

Condiția 2: Peste 20 de ani, mamei i se potriveste două ori mai mult decât fiicei.

$$(y + 20) = 2(x + 20)$$

Acum, vom rezolva aceste ecuații pentru a găsi vârsta fiicei și a mamei acum.

Înlocuim $y$ din prima ecuație în a doua ecuație:

$$(4x + 20) = 2(x + 20)$$

Rezolvăm pentru $x$:

$$4x + 20 = 2x + 40$$

$$4x - 2x = 40 - 20$$

$$2x = 20$$

$$x = 10$$

Deci, fiica are acum 10 ani.

După aceea, calculăm vârsta mamei:

$$y = 4x = 4 \times 10 = 40$$

Deci, mamei i se potriveste 40 ani acum.

Verificăm dacă condiția 2 este îndeplinită:

$$(y + 20) = 2(x + 20)$$

$$(40 + 20) = 2(10 + 20)$$

$$60 = 2 \times 30$$

$$60 = 60$$

Condiția 2 este îndeplinită.

Deci, acum fiica are 10 ani, iar mamei i se potriveste 40 ani.Concluzie

Modelele AI Jamba 1.5 sunt cu adevărat impresionante și au un cost relativ redus pentru utilizare:

- Jamba 1.5 Mini: 0.2 $/ 1M input + 0.4 $ / 1 M output

- Jamba 1.5 Large: 2$ / 1M input + 8$ /1 M output

Aceste prețuri și calitatea lor extraordinară le fac foarte atractive și compensează faptul că deși sunt open source nu pot fi utilizate în mod curent direct pe dispozitivele personale.

Totuși prin faptul ca sunt open source nu există nici un impediment pentru gâzduirea lor pe infrastructura on cloud a organizației.