Când majoritatea oamenilor se gândesc la Modele Lingvistice Mari (LLM), își imaginează servere cloud masive și abonamente costisitoare. Dar îți vom prezenta în acest articol 10 modele AI SLM care funcționează cu mai puțin de 8GB RAM extrem de puternice.

Datorită cuantizării de ultimă generație și optimizării modelelor, poți rula aceste SLM-uri direct pe laptopul sau desktopul tău, chiar dacă nu ai un calculator foarte puternic. Imaginează-ți că SLM-urile sunt ca omuleții din Lilliput, iar LLM-urile sunt ca uriașul Guliver.

1. Cum funcționează LLM-urile mici (SLM-urile) pe un calculator modest

Secretul este cuantizarea – un proces care reduce ponderile modelului de la floating-point-uri de 16 sau 32 biți la numere întregi de 4 sau 8 biți, scăzând drastic cerințele de memorie fără o pierdere semnificativă a calității. De exemplu, un model cu 7 miliarde de parametri care ar avea nevoie în mod normal de 14GB în FP16 poate rula în doar 4-5GB cu cuantizarea de 4 biți.

Concepte cheie:

- VRAM vs. RAM: memoria VRAM (de pe placa ta grafică) este rapidă și ideală pentru inferența LLM; RAM (memoria sistemului) este mai lentă, dar mai abundentă. Pentru cele mai bune rezultate, păstrează modelul în VRAM;

- Formatul GGUF: formatul de referință pentru modelele cuantizate, compatibil cu majoritatea motoarelor de inferență locale;

- Tipuri de Cuantizare: Q4_K_M este un de echilibru pentru calitate și eficiență; Q2_K sau IQ3_XS economisesc mai mult spațiu, dar pot reduce calitatea rezultatelor;

- Suprapunerea memoriei: alocă întotdeauna aproximativ 1.2x dimensiunea fișierului modelului pentru a ține cont de activări și contextul promptului.

2. Instrumente folosite pentru rularea SLM-urilor locale

Există mai multe instrumente disponibile pentru a te ajuta să începi:

- Ollama: un instrument CLI (Command Line Interface) sau mai nou sub formă de aplicație în Windows, prietenos pentru dezvoltatori pentru a rula LLM-uri local. Este rapid, scriptabil și acceptă ambalarea personalizată a modelului prin intermediul fișierelor Modelfile. Perfect pentru programatori și profesioniști în automatizare.

- LM Studio: ideal dacă preferi o interfață grafică cu multe setări. LM Studio oferă o aplicație desktop elegantă cu chat integrat, descărcare ușoară a modelelor de pe Hugging Face și ajustare simplă a parametrilor. Excelent pentru începători și cei care nu sunt programatori.

- Llama.cpp: motorul C++ care alimentează multe instrumente LLM locale, optimizat pentru modelele GGUF și accelerare CPU/GPU.

3. Top 10 Modele SLM locale mici (toate sub 8GB!)

Iată în continuare o listă cu 10 modele pe care noi le-am încercat și le utilizăm în mici aplicații locale. Vom vedea că pe cerințe specifice, toate aceste modele vor depăși modelele LLM la viteză, cost și rezultate.

Llama 3.1 8B (Cuantizat)

Folosind Ollama, acest model se poate instala cu comanda:

ollama run llama3.1:8bLlama 3.1 8B de la Meta este remarcabil pentru AI de uz general, lăudându-se cu un set de date uriaș de antrenament și optimizări inteligente. Versiunile cuantizate, cum ar fi Q2_K (3.18GB fișier, ~7.2GB memorie) și Q3_K_M (4.02GB fișier, ~7.98GB memorie) îl fac accesibil pentru majoritatea laptopurilor. Excelent pentru chat, cod, sumarizare și sarcini RAG (Retrieval-Augmented Generation) și este preferat pentru procesarea în loturi și fluxuri de lucru agențiale.

Am testat acest model SLM pentru o situație tipică, cu care se confruntă numeroase companii, și anume identificarea SPAM-ului din emailuri.

Mesajul analizat este:

"from: katarina.piljic@elite.hr

Bună dimineața,

Vă rugăm să găsiți atașate comanda noastră nouă și termenii contractuali revizuiți.

Vă rugăm să ne trimiteți o copie semnată ca confirmare. Așteptăm, de asemenea, factura dumneavoastră

Cu stima / Saygilarimizla / Regards

În cazul unor eventuale daune, în conformitate cu articolul 23/3 din Convenția Internațională CMR și în conformitate cu „principiul răspunderii limitate”, compania noastră este răspunzătoare doar pentru 8,33 DST per greutatea brută în kg lipsă a mărfurilor deteriorate (aproximativ € 10 pe kg). Transportatorul nu va fi răspunzător pentru prejudiciu dacă paguba sau întârzierea a fost cauzată de cauze pe care transportatorul nu le-ar fi putut evita sau preveni, în ciuda exercitării celei mai mari precauții (forță majoră).

(Convenția CMR 17/2) De asemenea, ambalarea necorespunzătoare efectuată de expeditor în formarea prejudiciului; Transportatorul este exonerat de răspundere pentru daunele cauzate de vicii în operațiunile de încărcare, descărcare și reparare efectuate de expeditor (Convenția CMR 17.4b/c) În caz de avarie, trebuie să aveți „Asigurare de mărfuri de transport” pentru a vă acoperi întreaga pierdere. și să nu fie victimizat.

Vă trimitem pentru informarea dumneavoastră.

Axinte MADALINA "Răspunsul SLM-ului a venit foarte rapid:

După ce am analizat mesajul, pot spune că este probabil un tip de spam într-un anumit sens. Aici sunt motivele:

1. **Mesajul nu este clar**: Mesajul pare a fi o combinație de cereri și informații legate de transporturi, dar nu este deloc clar ce conține exact.

2. **Termenii contractuali revizați**: Oricând apare într-un mesaj o referire la termenii contractuali, este un semn potrivit pentru acuratețe.

3. **Încheierea cu reguli de răspundere**: Încheierile cu reguli de răspundere limitate sau exonerare din răspundere sunt mai frecvente în cazurile spam.

4. **Lipsa identificării precise a ofertei**: Mesajul nu menționează în mod clar ce este oferta pe care o face și nici nu există detalii despre produs sau serviciu.

În ciuda acestor semne, există și argumente că nu este un mesaj de tip spam clasic. Motivul pentru care pot spune asta este:

1. **Mesajul pare a fi trimis din partea unei companii**: Mesajul are un format profesional și menționează o adresă e-mail a unui furnizor (elite.hr). Acest lucru sugerează că poate fi o comunicare oficială.

2. **Informațiile oferite sunt legate de transporturi**: Informațiile despre transporturi și condiții specifice ar putea fi relevante în contextul activităților unor companii.

Din punctul meu de vedere, mesajul nu este un tip de spam comun care vizează să cumpere sau să vinde produse fizice. Dar are un element neprecizat și puțin clar, ceea ce poate fi o încercare de a manipula destinatarul.

Am adăugat o informație modelului și anume că noi nu vindem produse fizice, ci doar consultanță. Modelul a reanalizat mesajul și a venit cu următoarea concluzie:

În acest caz, mă îndoiesc tot mai mult că mesajul este o comunicare oficială sau normală. Faptul că menționează "greutate" și referirea la CMR

(Convention Internationale sur T.S.R.) sugerează că e vorba despre transporturi de bunuri.

Mai mult, atenția acordată detaliilor legate de răspundere limitată, exonerare din răspundere și asigurarea mărfurilor de transport indică faptul că

mesajul are o intenție precisă: să împiedice pe destinatar să solicite despăgubiri sau să ia acțiuni juridice.

În această situație, cred că mesajul este un tip de spam în care se încearcă să se protejeze furnizorul de eventuale responsabilități legale prin

folosirea unui limbaj tehnic și a condițiilor contractuale. Acest tip de comportament este caracteristic spamurilor comerciale.

Dacă ești în situația de a primi astfel de mesaje, ar fi bine să nu mai interacționezi cu ei. Iar dacă ești clientul unei companii care s-ar putea

afla implicată în această activitate, ar trebui să discuți despre asta cu reprezentanții companiei pentru a clarifica situația.

În concluzie, cred că mesajul nu este o comunicare oficială sau normală și se potrivește mai mult tipului de spam.În concluzie, cu un pic de informații suplimentare sau fine-tuning, modeul SLM se descurcă excelent.

2. Mistral 7B (Cuantizat)

Folosind Ollama, acest model se poate instala cu comanda:

ollama run mistral:7bMistral 7B (unul din primele modele AI europene) este proiectat pentru viteză și eficiență, folosind GQA și SWA pentru performanțe de top. Cuantizările Q4_K_M (4.37GB fișier, 6.87GB memorie) și Q5_K_M (5.13GB fișier, 7.63GB memorie) sunt perfecte pentru configurații de 8GB. Este ideal pentru chatbot-uri în timp real, dispozitive de margine și utilizare comercială (licență Apache 2.0).

Gemma 3:4B (Cuantizat)

Folosind Ollama, acest model se poate instala cu comanda:

ollama run gemma3:4bGemma 3:4B de la Google DeepMind este mic, dar puternic. Q4_K_M (1.71GB fișier) rulează pe doar 4GB VRAM, făcându-l perfect pentru dispozitive mobile și PC-uri low-end. Excelent pentru generare de text, întrebări și răspunsuri (Q&A) și sarcini OCR (Optical Character Recognition).

Vom încerca să vedem dacă modelul poate identifica textul din următoarea imagine:

Modelul răspunde identificând corect textul:

describe the text in the image ./trend.jpg

Okay, let's analyze the text in the image ./trend.jpg.

The image contains the following text:

**"TREND2025"**

It’s presented in a bold, stylized font and with a gradient background effect that gives it a modern and eye-catching appearance. The overall design suggests a brand or product name.

Do you want me to delve deeper into any specific aspect of this text, such as:

* Its possible context (e.g., fashion, technology, etc.)?

* The font style and what it conveys?Modelul depășește cerința inițială și identifică chiar și stilul folosit în imagine și chiar presupune că e o imagine asociată cu moda.

Granite3.2-vision:2b (Cuantizat)

Folosind Ollama, acest model se poate instala cu comanda:

ollama run granite3.2-vision:2bGranite3.2-vision:2b (IBM) este un SLM multi modal cu capacități bune pentru a descrie imagini.

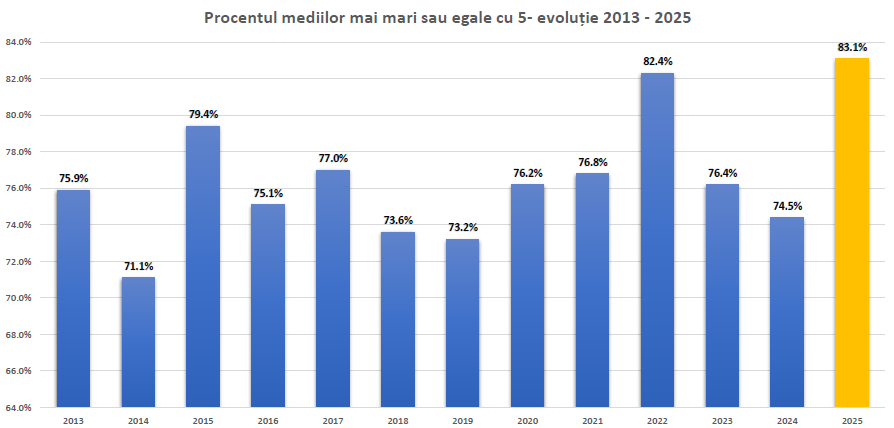

Să luam ca exemplu această imagine,

La analizarea graficului, modelul SLM ne-a dat următorul răspuns:

describe the image ./grafic.png

Added image './grafic.png'

The image is a bar chart titled "Procentul medilor mai mari sau egle cu 5- evolutie 2013 - 2025." The x-axis represents years from 2013 to 2025, while the y-axis represents percentages ranging from 64% to 84%. Each bar corresponds to a specific year and indicates the percentage of individuals who are either older or single with five or more children.

Here is a detailed breakdown of the data presented in the chart:

1. **2013**: The bar for this year reaches up to approximately 75% on the y-axis, indicating that around 75% of individuals were either older or

single with five or more children.

2. **2014**: There is a noticeable decrease in the percentage from 2013, dropping slightly below 75%. The bar reaches up to about 74%.

3. **2015**: Another significant drop occurs, with the bar reaching approximately 73% on the y-axis.

4. **2016**: There is a slight increase from 2015, with the bar reaching up to about 74%.

5. **2017**: The percentage increases again, reaching around 76%.

6. **2018**: A further increase is observed, with the bar reaching approximately 79%.

7. **2019**: There is a slight decrease from 2018, dropping slightly below 79%. The bar reaches up to about 75%.

8. **2020**: Another significant drop occurs, with the bar reaching approximately 76%.

9. **2021**: The percentage increases again, reaching around 76%.

10. **2022**: There is a slight decrease from 2021, dropping slightly below 76%. The bar reaches up to about 74%.

11. **2023**: Another significant drop occurs, with the bar reaching approximately 75%.

12. **2024**: There is a slight increase from 2023, with the bar reaching around 76%.

13. **2025**: The percentage increases again, reaching up to about 84%.

### Analysis and Description:

The overall trend indicates a slight increase in this percentage, with some years showing significant drops.

- **2013**: The percentage is around 75%.

- **2014**: A slight decrease to approximately 74%.

- **2015**: Another drop to about 73%.

- **2016**: An increase to around 74%.

- **2017**: The percentage increases again, reaching approximately 79%.

- **2018**: A slight decrease to below 79%, with the bar reaching up to about 75%.

- **2019**: Another significant drop to around 76%.

- **2020**: The percentage increases again, reaching approximately 76%.

- **2021**: A slight decrease from 2020, dropping slightly below 76%.

- **2022**: Another slight decrease to about 75%.

- **2023**: An increase to around 76%.

- **2024**: The percentage increases again, reaching approximately 84%.

- **2025**: The total percentage for the years 2013-2025 combined reaches up to about 84%, as indicated by the yellow bar at the top right corner.

Chiar dacă are aceleași rezultate bune ca frații săi mai mari, acest model SLM poate fi folosit la rezumarea documentelor care conțin imagini, putând să identifice corect contextul sau conținutul graficelor sau tabelelor.

Phi-3 Mini (3.8B, Cuantizat)

Folosind Ollama, acest model se poate instala cu comanda:

ollama run phi3Phi-3 Mini de la Microsoft este o putere compactă pentru logică, codare și matematică. Q8_0 (4.06GB fișier, 7.48GB memorie) se încadrează bine în limita de 8GB. Este excelent pentru chat, mobil și sarcini sensibile la latență.

Vom testa acest model pentru generarea unui cod de extragere date dintr-o schemă json:

[

{

"name":"Paul",

"age":"32"

},

{

"name":"Maria",

"age":"42"

},

{

"name":"Victor",

"age":"52"

},

]Modelul SLM Phi3-Mini propune un script python și ne dă și răspunsul la cererea de extragere a informației:

To extract only the names from the provided JSON data, you can iterate through each object and collect the values associated with the key `"name"`.

Here's a Python example to achieve this:

```python

import json

data = [

{

"name": "Paul",

"age": "32"

},

{

"name": "Maria",

"age": "42"

},

{

"name": "Victor",

"age": "52"

},

]

# Extract the names

names = [person["name"] for person in data]

print(names)

```

Running this code will output:

```python

['Paul', 'Maria', 'Victor']

```

This approach uses a list comprehension to iterate through each dictionary in the JSON array and extract the value associated with the key `"name"`.Observăm că modelul a identificat corect numele: ‘Paul’, ‘Maria’, ‘Victor’.

În practică putem folosi acest model (direct sau antrenat special) pentru a extrage rapid anumite date dintr-un document, de pildă un tabel, într-o anumită structură pe care ne-o dorim.

DeepSeek R1 7B/8B (Cuantizat)

Folosind Ollama, acest model se poate instala cu comanda:

ollama run deepseek-r1:7bModelele DeepSeek 7B și 8B sunt renumite pentru raționament și cod. R1 7B Q4_K_M (4.22GB fișier, 6.72GB memorie) și R1 8B (4.9GB fișier, 6GB VRAM) sunt ambele prietenoase cu 8GB. Sunt ideale pentru IMM-uri, suport pentru clienți și analiză avansată a datelor.

Vom testa acest model la extragerea datelor dintr-un document de tip Markdown (de exemplu o factura prelucrată anterior). Documentul propus este:

Extract the price values from this markdown:

| Tables | Are | Cool |

|----------|:-------------:|------:|

| col 1 is | left-aligned | $1600 |

| col 2 is | centered | $12 |

| col 3 is | right-aligned | $1 |

Am cerut lui DeepSeek R1 7B:8B să extragă prețurile, deci va trebui să identifice coloanele și valorile corespunzătoare și să determine care dintre aceste valori este de tip preț.

Thinking...

Alright, so I have this markdown table here. Let me take a look.

The first row after the header has "col 1 is", "col 2 is", and "col 3 is". Then there are three columns with values like $1600, $12, and $1.

I need to extract just the numbers from these cells. The cells in the second column have dollar signs, so I'll need to remove those as well.

...done thinking.

To extract the price values from the markdown table:

1. **Identify the numeric values**:

- From "col 3 is", we get \$1600

- From the next row: \$12

- And finally, \$1

2. **Remove any non-numeric characters (like dollar signs)** to isolate just the numbers.

Here are the extracted price values:

| Value |

|-------|

| 1600 |

| 12 |

| 1 |Avantajul acestui model este că folosește algoritmi primari de raționament, deci el deduce niște reguli (chiar dacă nu i le-am specificat noi) și le folosește pentru a identifica corect datele.

Qwen 1.5/2.5 7B (Cuantizat)

Folosind Ollama, acest model se poate instala cu comanda:

ollama run qwen:7bModelele Qwen 7B de la Alibaba sunt multilingve și bogate în context (32K token-uri). Qwen 1.5 7B Q5_K_M (5.53GB) și Qwen2.5 7B (4.7GB, 6GB VRAM) sunt perfecte pentru chatbot-uri, traducere și ajutor la programare.

Deepseek-coder-v2 6.7B (Cuantizat)

Folosind Ollama, acest model se poate instala cu comanda:

ollama run deepseek-coder-v2:6.7bDeepseek-coder-v2 6.7B este visul unui programator – ajustat pentru generarea și înțelegerea codului. Cu 3.8GB (6GB VRAM), este o alegere de top pentru completarea locală a codului și instrumentele pentru dezvoltatori.

BitNet b1.58 2B4T

Folosind Ollama, acest model se poate instala cu comanda:

ollama run hf.co/microsoft/bitnet-b1.58-2B-4T-gguf

BitNet b1.58 2B4T de la Microsoft este o minune a eficienței, folosind greutăți de 1.58 biți pentru a rula în doar 0.4GB de memorie. Este perfect pentru dispozitive de margine, IoT și inferență numai pe CPU – gândește-te la traducere pe dispozitiv și asistenți mobili.

Orca-Mini 7B (Cuantizat)

Folosind Ollama, acest model se poate instala cu comanda:

ollama run orca-mini:7bOrca-Mini 7B, construit pe Llama și Llama 2, este un model flexibil pentru chat, Q&A și urmărirea instrucțiunilor. Q4_K_M (4.08GB fișier, 6.58GB memorie) și Q5_K_M (4.78GB fișier, 7.28GB memorie) sunt ambele prietenoase cu 8GB. Este excelent pentru construirea agenților AI și a instrumentelor conversaționale.

4. Concluzie: modele SLM mici – avantaje mari

Modelele prezentate mai sus – Llama 3.1 8B, Mistral 7B, Gemma 3:4B și 7B, Phi-3 Mini, DeepSeek R1, Qwen 7B, Deepseek-coder-v2, BitNet b1.58 și Orca-Mini – demonstrează că nu ai nevoie de un supercomputer pentru a valorifica AI. Datorită cuantizării și inovației open-source, poți rula modele lingvistice avansate pe hardware de zi cu zi.

De ce contează asta?

- Confidențialitate: păstrează-ți datele local – nu este necesar cloud;

- Cost: fără abonamente sau taxe de cloud;

- Viteză: răspunsuri instantanee, chiar și offline;

- Flexibilitate: experimentează, personalizează și implementează oriunde.

Pe măsură ce cuantizarea și AI dedicat dispozitivelor cu resurse limitate continuă să avanseze, te poți aștepta la modele și mai puternice care rulează pe dispozitive mai mici.

În plus un model mic poate fi antrenat să rezolve sarcini specifice mult mai repede și mai ieftin!